اولین و دومین نسل پردازنده های Xeon Intel و ارتقا به نسل پنجم

از سال 2017 تا سال 2021 پردازنده های Xeon که بر مبنای سوکت LGA3677 در حجم زیادی فروخته می شد. آن سرور ها هم اکنون 3 تا 6 ساله هستند و این بدین معنی است که این سرورها دقیقا در دوره ای هستند که چرخه های جایگزینی شروع می شود.

این دومین نیمه از داستانی است که ما می خواهیم درباره ی پردازنده های نسل پنجم Xeon تعریف کنیم.

ما از شرکتهای Intel و Supermicroدرباره ی راه اندازی دو سرور تقاضا کردیم. ما یک سرور از نسل قدیمی تر و یک سرور از نسل جدیدتر داریم اما با کمی پیچیدگی به جای این که دوتا از بالاترین بخش ها را که شبیه آنچه ما معمولا می بینیم و درباره اش صحبت می کنیم. ما می خواهیم بر روی سطوح SKU چرخه جایگزینی با حجم بالاتر تمرکز کنیم.

من می خواستم که نسل دوم پردازنده های Xeon موسوم به “Cascade Lake” به عنوان نقطه مقایسه استفاده کنم، زیرا در شروع سه ماهه دوم سال 2021 متداول ترین پردازنده Xeon بودند و پردازنده های نسل سوم Xeon موسوم به Ice Lake کمی زمان برد تا متداول بشود.

مردم درباره AMD EPYC تعجب می کنند. اما سری EPCY 7001 نفوذ بسیار محدودی در بازار داشت و نسل دوم EPCY 7002 شروع به فراگیرشدن کرد.

اما اکثریت قریب به اتفاق مردم یعنی 90 درصد به بالا اگر در یک چرخه 3 تا 6 ساله به روز رسانی باشند، از نسل اول یا نسل دومXeon Scalable ارتقا خواهند یافت.

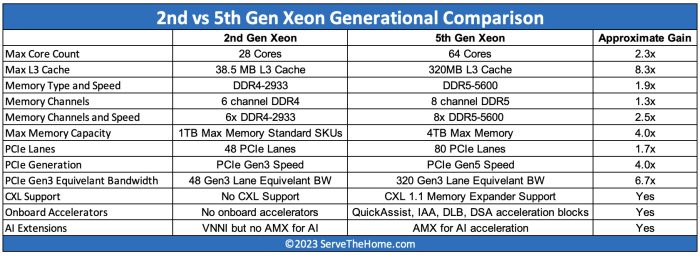

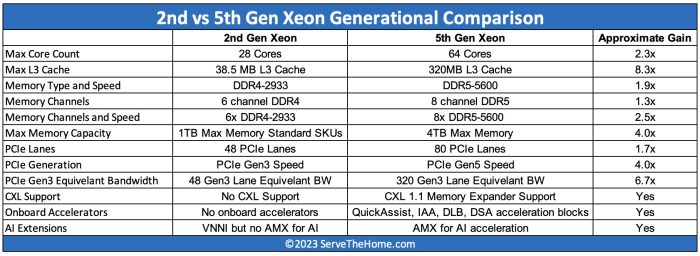

ابتدا اجازه بدهید درباره مقایسه بین نسلی در سطحی بالاتر صحبت کنیم. این جهش بزرگی نیست که بگوییم نسل جدید فقط سریعتر است و هسته های بیشتری دارد. شاید مهمترین نکته این باشد که تعداد هسته ها با همان سرعت بقیه پلتفرم افزایش نیافته است. تقریبا هرچیزی دیگری در مورد این پلتفرم در دو سال ونیم گذشته بیش از 2.3 برابر افزایش داشته است.

جدا از این واقعیت پلتفرم X13 چهار جای هارد درایو خالی دارد. به دلیل این که نمونه اولیه آزمایشی که در رک قرار داده شد و این بسیار سخت خواهد بود که تفاوتشان گفته شود.

بسیاری- ممکن است فرض کنند این بدین معنی است که آنها شبیه پلتفرمهای تک یونیت دو پردازنده ایی هستند و این بطور فاحشی نادرست است.

بخش جلوی X13 جدیدتر از SSD هایی پشتیبانی می کند که چهار برابر سریعتر از سیستم قدیمی تر وSSD هایی جدیدتر که تمایل به داشتن ظرفیت بالاتر نیز هستند.

اما در داخل سرور جایی است که تغییرات واقعی اتفاق می افتد. اینجا است که یک سرور در داخل نسلی که شروع به جایگزینی می کند رخ نشان می دهد.

به موارد زیر توجه کنید:

1-فن ها قابلیت تعویض درجا(hot-swap) ندارند.

24-2 اسلات DDR4 داریم.

3- راهنمای جریان هوای انعطاف پذیر هستند. (نمایش داده نشده است)

4-کابل ها مسیرهای PCIe را به محل های ذخیره سازی قسمت جلو می برند.

5- Riser های پشتی مبتنی بر اسلات هستند.

6- پورتهای SATA هنوز وجود دارند.

7- چیپ پردازشگر مدیریت سرورمدل ASPEED AST2500 BMC است.

8- شبکه سازی بر روی یک ماژول فرم فاکتور سفارشی است.

9- مادربورد به بخش عقبی شاسی گسترش یافته است.

1- هدرهای بزرگ PCIe برای کارت گرافیک ها.

و اما نگاهی به سیستم های جدید بیاندازیم.

1-فن ها قابلیت تعویض درجا(hot -swap) دارند.

2-دارای 32 اسلات DDR5 هستند.

3- راهنماهای جریان هوای سخت.

4-هدرهای PCIe نسل پنجم برای اسلاتهای SSD NVMe ارتقا یافته اند.

5- RISER های عقبی مبتنی بر اسلات وکابل هستند.

6-پورتهای از رده خارج SATA 6Gbps دیگر وجود ندارند وM.2 برای boot کردن به کار می رود.

7- چیپ پردازشگر مدیریت سرور مدل ASPEED AST2600 BMC است.

8- شبکه سازی با یک ماژولOCP NIC 3.0 برای سرویس دهی بدون ابزار و حتی بی نیاز از باز کردن درب سرور می باشد.

9- مادربورد تا زیر منابع تغذیه گسترش پیدا کرده است.

10- هدرهای برق کوچکتر برای اسلات PCIe کارتهای گرافیک.

والبته این موارد ممکن است که چیزهای کوچکی و امور بی اهمیتی به نظر برسند اما این یک کوچ بزرگ از طراحی های فقط دو سال پیش است هنگامی که مجموع تغییرات بزرگ به نظر می رسد.

همچنین در نظرداشته باشید که شتاب دهنده هایی مثل Quick Assist که درداخل SKU هایی که آنها را پشتیبانی می کند درحالی که در نسلهای قبلی یک اسلات PCIe را اشغال را می کردند.

بعد، اجازه بدهید درمورد عملکرد صحبت کنیم.

برای نگاه کردن به کارایی من می خواستم بر روی چیز دیگری غیر از بهترین گزینه تمرکز کنم و این امر منجر به شروع پروسه ای شد که کدام پردازنده را به کار ببریم.

به همین منظور من ازSupermicro تقاضا کردم که محبوبترین SKU متداول چیست برای نسل دوم پردازنده های Xeon server .

آن ها در داده های داخلیشان جستجو کردند که می تواند توسط چند مشتری بزرگ منحرف بشود، اما این بهترین چیزی بود که ما در دسترس داشتیم.

این چیزی بود که ما را به پردازنده Xeon Gold 6252 که پردازنده 24 هسته ای می باشد هدایت کرد.

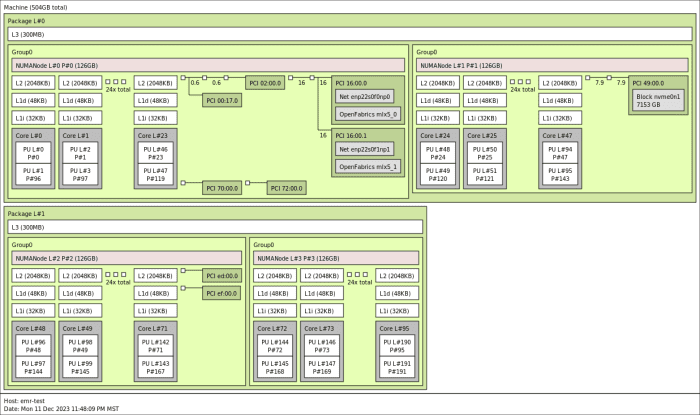

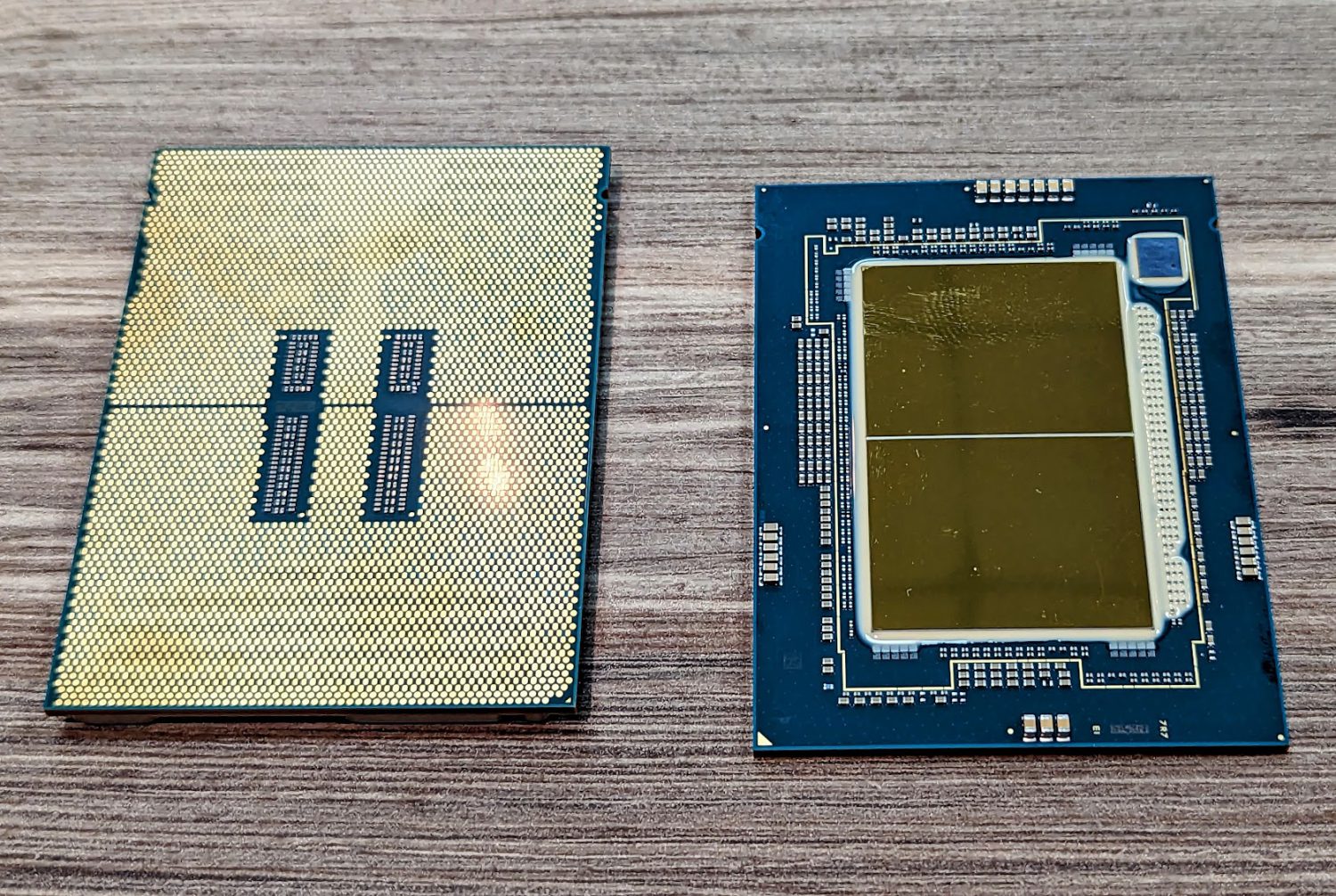

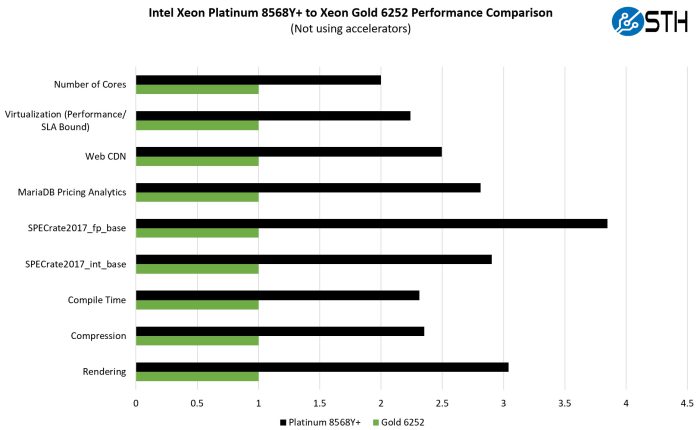

برای نسل پنجم از آنجایی که تعداد هسته های ما بیشتر است، من فکردم که داشتن پردازنده ای با تعداد هسته های دو برابر برخی از مقایسه ها را آسان تر می کند، بنابر این چندین پردازنده را پیدا کردیم و به پردازنده Xeon Platinum 8568Y+ Intel رسیدیم.

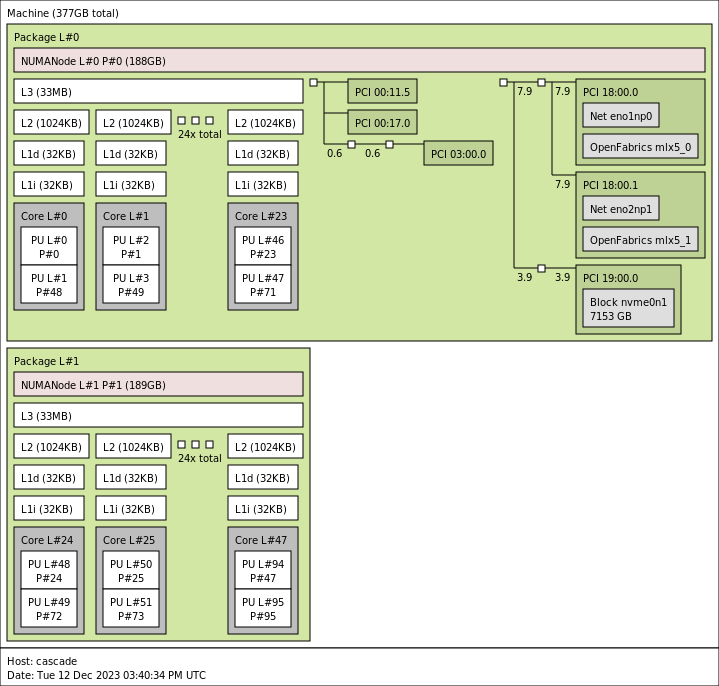

اینجا به نظر می رسد که NPS=2 در هر سوکت چگونه است، بنابراین به دو بخش منطقی 24 هسته ایی تقسیم می شود.

هم اکنون، بسیاری از سازمانها هستند که هسته ها را به ماشین های مجازی اختصاص می دهند و سپس از آن هسته ها بسیار کمتر از توان و ظرفیت کار می کشند و ما دراینجا شاهد هدر رفتن بخش زیادی از قدرت پردازشی پردازنده هستیم.

یک مثال برای روشن شدن این مطلب این است که به برنامه هایی فکر کنید که دو یا چهار پردازنده مجازی از ماشین مجازی می گیرد و سپس برای سال ها فقط 5 درصد کارایی پردازنده را به کار می برد و 95 درصد بقیه توان پردازشی پردازنده بدون استفاده می ماند و به هدر می رود.

اگر سازمان شما فقط صرفا از تعداد هسته ها استفاده می کند و برایش توان پردازشی مورد استفاده هر هسته مهم نیست نسبت ادغام دو به یک است و از24 هسته به 48 هسته پردازنده تغییر می کند. همان طور که در این بخش نشان خواهیم داد، کارایی به ازای هر هسته سریع تر می باشد، اما برای بسیاری از سازمانها، برآورد کردن به روز رسانی به این صورت اتفاق می افتد.

برای آنهایی که به کارایی اهمیت می دهند. ما تعدادی اعداد برای شما داریم.

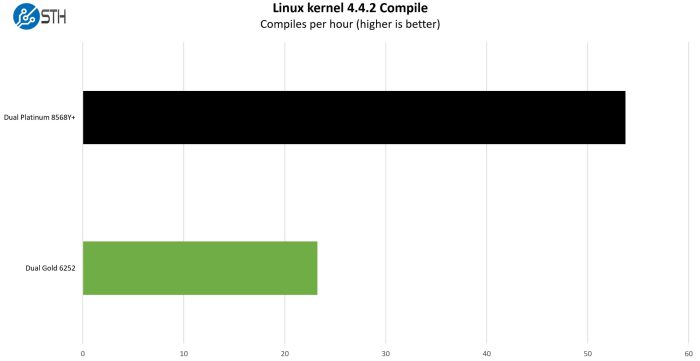

Python Linux 4.4.2 Kernel Compile Benchmark

این یکی از پرتقاضاترین Benchmark هایی هست که برای سایت ما در چند سال گذشته است .

کار ساده بود: ما یک فایل پیکر بندی استاندارد داشتیم، هسته لینوکس 4.4.2 از kernel.org، و پیکربندی استاندارد تولید خوکار را با استفاده از هر رشته در سیستم ایجاد کردیم. ما نتایج را برحسب کامپایل در ساعت بیان می کنیم تا خوانایی نتایج آسانتر شود.

در حدود 2.3 برابرکارایی، شاهد افزایش بیشترکارایی کل نسبت به تعداد هسته ایی هستیم که ما را به آن سوق می دهد.

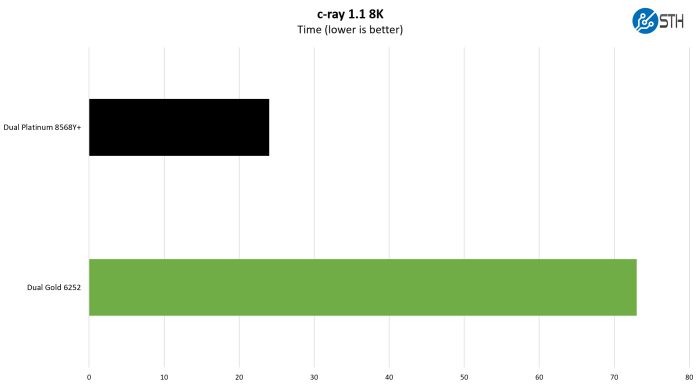

c-ray 1.1 Performance

ما سال هاست که ازc-ray برای تست عملکرد خود استفاده می کنیم. این یک معیار ردیابی پرتو است که برای نشان دادن تفاوتها در پردازنده ها تحت کاربارهای چند رشته ایی بسیار محبوب است.

دراینجا نتایج 8K آمده است:

این جایی است که معماری جدید با عملکردی نزدیک به 3 برابر بهتر عمل می کند. صادقانه بگویم، این یکی از معماری هایی است که بهتر از بقیه معماری ها عمل می کند.

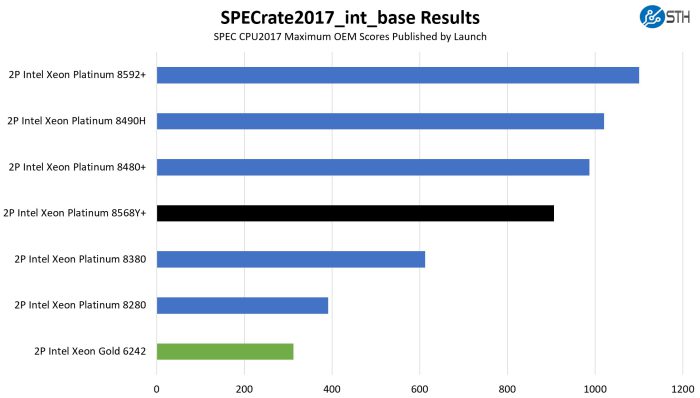

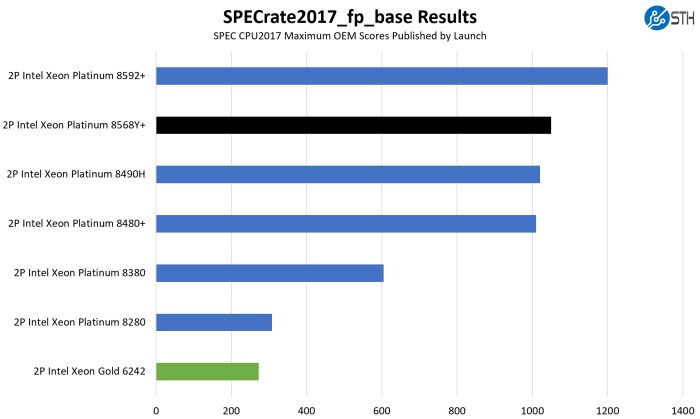

SPEC CPU2017 Results

SPEC CPU 2017 شاید شناخته شده ترین و مورد استفاده ترین معیاردر RFPهای سرور باشد.

ما تستSPEC CPU 2017 خود را انجام می دهیم و نتایج ما معمولا چند درصد کمتر از آنچه که تولید کننده اصلی قطعات به عنوان نتایج رسمی ارائه می کنند است. واین فقط به دلیل این است که تمام کارهای بهینه سازی که برای این معیارهای مهم انجام می دهند، حدود 5 درصد ثابت است. این کمی متفاوت از یک راه اندازی معمولی است زیرا قبلا اعداد عملکرد را منتشر کرده اند، بنابراین اگر در مورد معیار صحبت می کنیم استفاده از اعداد رسمی درست به نظر می سرد.

ابتدا، ما قرار است متداول ترین معیار سازمانی و ابری، یعنی عملکرد نرخ صحیح SPEC CPU 2017 را نشان دهیم.

در سمت ممیزشناور این ارقام هستند:

ما برخی از ارقام را برای هر نسل در گوشه های بالای نمودار قرار دهیم و همچنین اعداد را در جای درست و مناسبش قرار دهیم. دو SKU که ما داریم که در سطح بالاترین ها نیستند، اما درنیمه بالاییSKU برای نسل خود قرار دارند. سمت عدد صحیح تقریبا 2.9 برابر افزایش یافت، در حالی که سمت ممیز شناور به 3.8 برابر نزدیکتر بود. اینها برای ده چهارم سود بسیار بزرگی هستند.

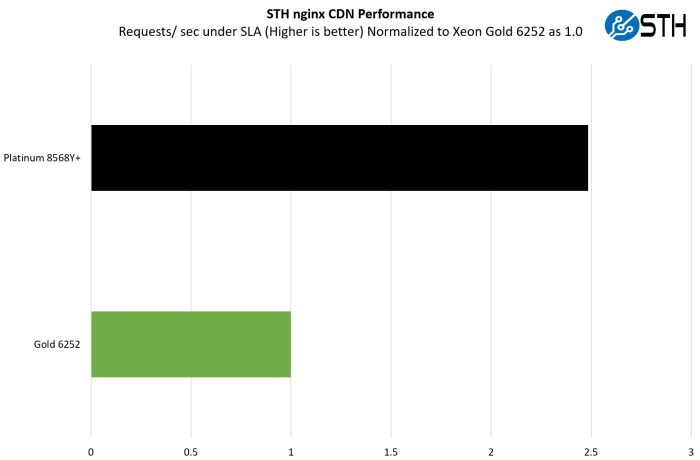

STH Nginx CDN Performance

Nginx یک وب سرور open source و قدرتمند است که کارایی بالایی دارد.

درتست Nginx CDN، ما از یک نرم افزار snap shot قدیمی استفاده کردیم و الگوهای دسترسی قدیمی از وبسایت خودمان استفاده می کنیم و با این شرط که caching DRAM غیرفعال است تا نشان دهیم عملکرد واکشی داده ها از دیسک ها چگونه به نظر می رسد. این به عملیات Nginx با تاخیر کم نیاز دارد، اما با افزودن یک مرحله اضافی از دسترسی ورودی/ خروجی با تاخیر کم ، که آن را در سطح سرور جالب می کند. در اینجا یک نگاه سریع به توزیع داریم :

با اجرای یک کارباری در دنیای واقعی افزایش عملکرد 2.5 برابری کارایی باعث شد که خجالت بکشیم.

اگر بخواهیم منصفانه باشیم، این نیز یک کارباری است که می تواند مشاهده کند که اتصالات SSL به شتاب دهنده های Quick Assist بارگذاری می شوند. درعین حال، یکی از برنامه های شاخص است که برای پردازنده های بومی ابری نیز می باشد.

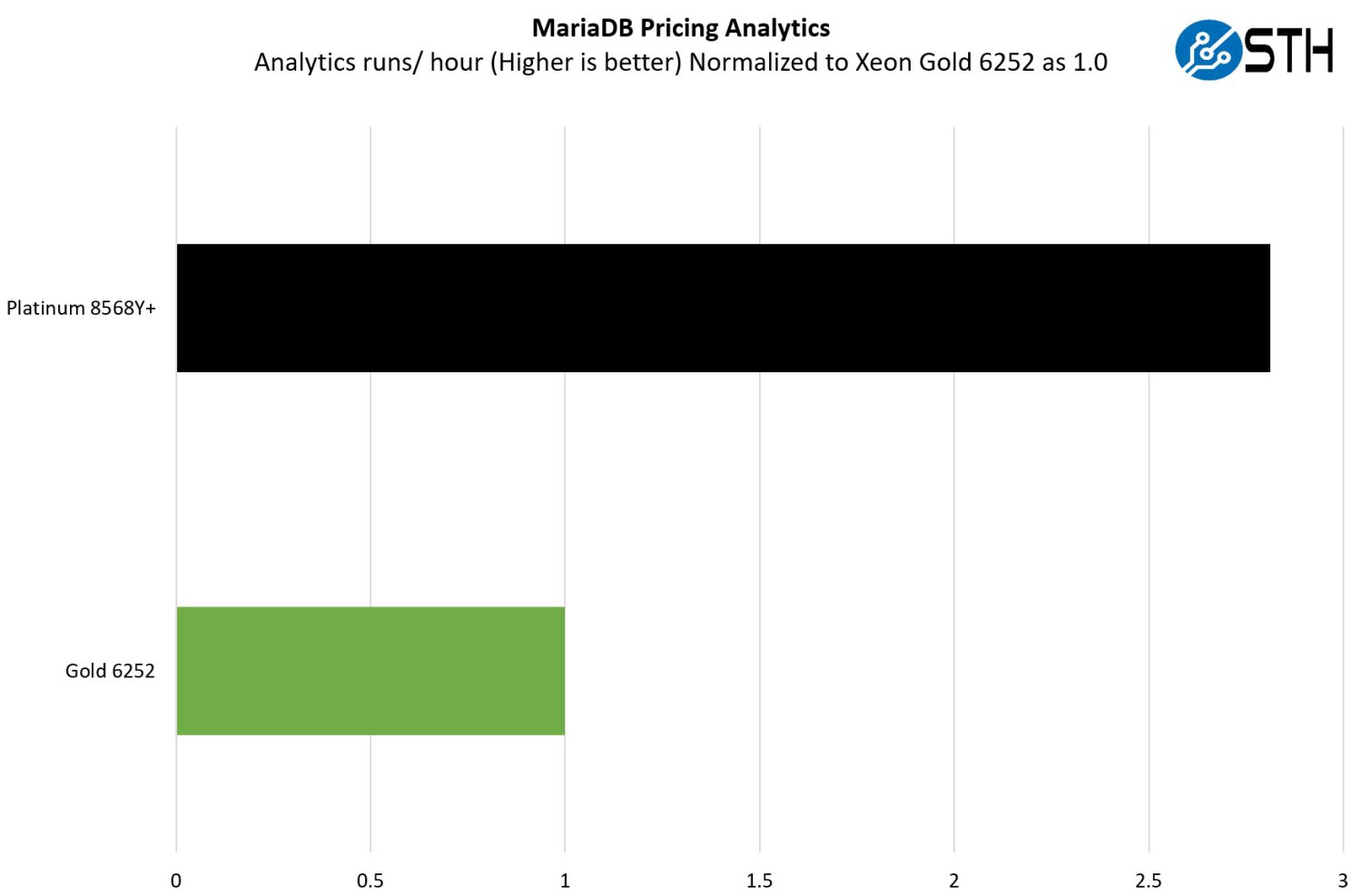

MariaDB Pricing Analytics

این برای من شخصا بسیار جالب است.

منشا این آزمایش این است که ما کارباری داریم که تجزیه و تحلیل قیمت گذاری مدیریت معامله را روی مجموعه ایی از داده هایی که از یک مرکزداده تولید کننده تجهیزات اصلی نانشناس شده اند، اجرا می کند. این برنامه به طور موثر به دنبال روندهای قیمت گذاری در خطوط تولید، مناطق وکانال ها می باشد تا راهنمایی های معامله خوب / بد را براساس روند بازار برای اطلاع رسانی تنظیمات BOM بلا درنگ تعیین کند. اگر این بسیار خاص به نظر می رسد، تفاوت بزرگ بین این و چیزی که در یک فروشنده بزرگ مستقر شده است ، داده هایی است که ما استفاده می کنیم. این نوعی برنامه کاربردی است که به روش های استتناج هوش مصنوعی منتقل شده است، اما یک مثال عالی در دنیای واقعی از چیزی است که یک کسب و کار ممکن است در فضای ابری اجرا کند.

در اینجا، سود خالص نزدیک به 2.8 برابر است.

امروزه شاید فردی که این برنامه به عنوان AI inferencing اجرا می کند و inferencing فرایند اجرای دادهای زنده به واسطه یک هوش مصنوعی است برای پیش بینی کردن و یا اجرای یک وظیفه می باشد.

AMX برای افزایش عملکرد بیشتر استفاده می کند، اما این یک مدل مالی است که باید دقیق باشد زیرا پیامدهای تشخیص درآمد برای شرکت وجود دارد.

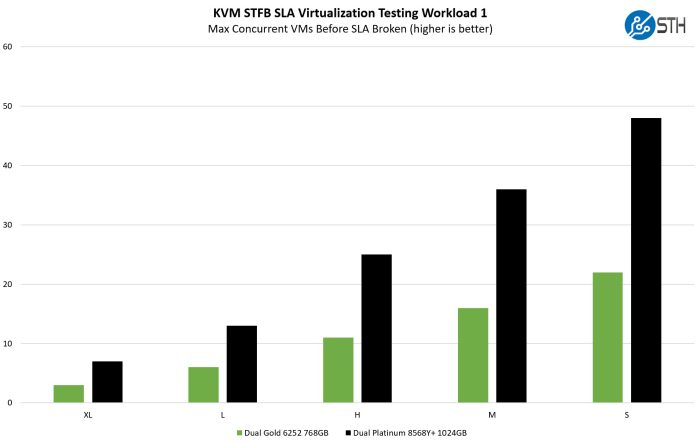

STH STTFP KVM Virtualization Testing

یکی از کاربارهای دیگری که می خواهیم به اشتراک بگذاریم، مربوط به یکی از مشتریان DemoEval است.ما مجوز انتشار نتایج را داریم، اما خود برنامه درحال آزمایش منبع بسته است. این یک کارباری مبتنی بر مجازی سازی KVM است که در آن مشتری ما در حال آزمایش چند ماشین مجازی در یک زمان معین در حین تکمیل کار تحت SLA هدف است. هرماشین مجازی یک کارگر مستقل است. از این نظرکاری که انجام می دهد بسیار شبیه VMware VMark است، فقط برای فراگیر بودن ازKVM استفاده می کند.

در سمت مجازی سازی، ما منغعت بیشتری از دو برابر بودن تعداد هسته ها و گاهی اوقات فقط به یک دلیل ساده.

داشتن اسلاتهای DIMM بیشتر به این معنی است که ما در پیکر بندی های خود حافظه بیشتری برای پردازنده های نسل پنجم Intel Xeon داریم و این چیزی است که به نتایج ماشینهای مجازی کوچک کمک می کند.

در سمت XL محدود بهCPU ، نتایج کمی نزدیک تر بود، اما نسل جدید همچنان به صورت گسترده ایی پیشتاز بود.

در حال حاضر، ما به طور خاص فقط بر روی کاربارهای قدیمی lift-and-shift تمرکز می کنیم.

lift-and-shift به معنی مهاجرت اپلیکیشن ها به سمت سرویس ابری می باشد و این به معنی اسباب کشی یک برنامه و داده ای مربوط به آن به پلتفرم ابری البته بدون طراحی مجدد اپلیکشین می باشد.

ما از ویژگی ها یی مثل Intel AMX که برای هوش مصنوعی به کار نمی بریم و حتی از سایر شتاب دهندهای داخلی نیزاستفاده نمی کنیم.

این ویژگی های ذکر شده منافع عمومی زیادی ارائه می کنند و

اما بسیاری از برنامه های قدیمی برای استفاده از این ویژگی ها ساخته نمی شوند. با بلوغ بسیاری از این کاربارهای قدیمی در سال2024 نامزد پردازنده های بومی ابری

(Cloud-Native Processors) خواهند بود.Cloud-Native Processors یا CNP ها برای کاربارهای متنوعی مثل وب سرویس ها و جستجو و تحلیل داده و پایگاه داده و تحلیل داده و هوش مصنوعی سرویس ای بازی و ارائه سرویس های رسانه های جمعی مناسب خواهند بود.

در مرحله بعد، اجازه دهید این را در درسهای کلیدی خود جمع بندی کنیم.

مصرف برق پردازنده های نسل دوم Xeon اینتل در مقایسه با پردازنده های نسل پنجم Xeon

برای این منظور ما از دو سرور Supermicro استفاده کردیم و در بخش مصرف برق یک مقایسه سریع سر به سر انجام دادیم.

مصرف برق در حالت بیکار معمولا برای سیستم نسل دوم Xeon Intel بین 80 تا 100 وات بود، در حالی که برای سیستم جدیدتر تقریبا دو برابر بود.

در سیستم تحت بار، سیستمهای قدیمی تر اغلب با حداکثر توان بین 600 تا 700 وات کار می کنند، در حالی که سیستم های جدیدتر در محدوده 900 تا یک کیلو وات بودند.

سیستم های جدیدتر آشکارا از برق بیشتری استفاده می کنند. در عین حال ،با فرض این که سیستم ها تا حدود 70 درصد بارگذاری شده اند، اغلب عملکردی 2 تا 3 برابری برای حدود 1.4 برابر مصرف برق دریافت می کنیم.

این واقعا قدرت تقویت شدن با تراشه های جدید است.

باز هم این موضوع در سال 2024 تبدیل به یک موضوع بزرگ خواهد شد، اما اگر سازمان دچار کمبود برق درمرکزداده خودش است، وعادت به خرید پردازنده های Xeon با هسته های پرتوان کرده است، این ایده را به شما می دهد که چه چیزی منتظر شماست.

در مرحله بعد، اجازه دهید به درس های کلیدی آموخته شده بپردازیم.

درسهای کلیدی آموخته شده از پردازنده تازه سازی شده Intel Xeon می باشد.

هنگامی که مقاله اولیه نسل پنجم Intel Xeon خود را منتشر کردیم، بسیاری ویدیوی ما را دیدند که یک مقایسه بین دو پردازنده 24 هسته ایی در مقابل یک پردازنده 48 هسته ایی بود و همچنین مقایسه استاندارد Intel با AMD را داشت و از برجسته کردن انتقال Intel به Intel بسیارهیجان زده شدند. بگذارید واضح بگوییم: به این دلیل است که چرخه های ارتقا معمولا این گونه عمل می کنند.

گزینه هایAMD در بازار وجود دارند وپردازنده های AMDهسته های زیادی دارد، اما اکثریت بازار هنوز پردازنده های Xeon را با همان پردازنده Xeon ارتقا می دهند.

و هدف این مقاله همین است.

آنچه ما یافتیم را می توان در چند درس کلیدی آموخته شده چکیده کرد.

اول، این که سرورهای جدید همه چیز را از هسته گرفته تا حافظه از PCIe I/O و همچنین شتاب دهنده داخلی بیشتری ارائه می کند.

داشتن بیشتر از همه چیز منجر به کارایی بیشتر می شود و اغلب شاهد عملکرد 2 تا 3 برابری در تنظیمات خود بودیم، در حالی که زمانی که سیستم ها در یک محیط مجازی به خوبی کارمی کنند، حدود 40% برق بیشتری مصرف می کنند.

با وجود این که سرورها یکسان به نظر می رسند. سرورهای جدید می توانند پیشرفتهای کارکردی عظیمی در زیر پوسته فلزیشان داشته باشند. بخشی از آن سرعت سریع تر پلتفرم زیر بنایی با ویژگی ها و نسل های جدید فناوری است. بخش دیگر صرفا بازخورد بیشتری است که با چند سال کار طراحی بیشتر وارد طراحی سرور می شود.

از زمانی به بعد افراد نیاز به ارتقای تجهیزات خواهند داشت.

اگر شما پردازنده نسل اول یا نسل دوم Xeon در اطرافتان دارید یا شاید پردازنده Xeon E5s امیدواریم این درس های کلیدی به راهنمایی این روند کمک کند.

کلمات پایانی

به طور کلی، سرورهای جدید عالی هستند.

ظرفیت و کارایی بیشتری نسبت به نسل های قبلی دارند. همچنین فاصله بسیار بیشتری بین سرورXeon سه ماه دوم سال 2021 و سرور سه ماه چهارم سال 2023 نسبت به سرورXeon سه ماه دوم 2021 و سرور سه ماه سوم 2017 وجود دارد.

امیدوارم ، این راهنما برای مردم مفید باشد. ما می دانیم که مردم از یه زمانی به بعد دنبال نوسازی خواهند بود زیرا ما هنوز برخی از سرورهایXeon نسل دوم را در کلاسترهای خود داریم. به جای این که صرفا به محتوای گرانترین سطح نگاه کنیم و پردازنده های پر هزینه 64 هسته ایی در مقابل پردازنده های 28 هسته ایی، هر دو با قیمت های فهرستی بیش از 10000 دلار را برجسته کنیم ، می خواستیم به بخشی که حجم بیشتری دارد تمرکز کنیم.

هوش مصنوعی آنچنان کاربرد داغی که در عرصه مراکز داده پیدا کرده است و که یکی از روش های فکر کردن در مورد ارتقا به یک سرور مدرن تر، دریافت قابلیتی مانند AMX برای هوش مصنوعی است. این همان چیزی هست که Intel می خواهد به بازار پیام بدهد. ما درارتباط با این موضوع مفیدتر فکر می کنیم.

ارتقا به سرورهای جدید به معنای فضای کوچکتر مرکز داده و قدرتمند کردن برای برنامه های سنتی است، بنابراین فضای بیشتری برای سرورهای شتاب دهنده برای هوش مصنوعی وجود دارد.

البته، فناوری پیشرفت می کند و ما در سال 2024 کارهای زیادی در فضای ابری انجام خواهیم داد. منتظر باشید تا این بخش به عنوان یک نیروی اصلی در دو سه سال آینده ظاهر بشود.